OpenAI, la société à l’origine de ChatGPT a annoncé ce lundi 13 mai 2024 son nouveau LLM (Large Language Model ou grand modèle de langage) dont les performances dépassent significativement tous les autres. Découvrez tout ce qu’il y a à savoir sur ce nouveau modèle multimodal qui repousse une nouvelle fois les limites de l’intelligence artificielle et de ses applications pratiques.

OpenAI met fin aux rumeurs

Le 28 avril 2024, un mystérieux nouveau modèle de langage a fait son apparition sur LMSYS, la plateforme de référence utilisée par les experts de l’IA pour effectuer des tests comparatifs à l’aveugle entre différents modèles.

Baptisé tantôt “gpt2-chatbot”, “im-a-good-gpt2-chatbot” ou encore “im-also-a-good-gpt2-chatbot”, ce nouveau modèle venu de nulle part a surpris tous les spécialistes grâce à ses performances hors normes lui permettant de se hisser au sommet du classement des modèles les plus performants de la plateforme. Ce classement se présentait alors ainsi :

Dans un post sur X, la plateforme avait félicité “l’écart considérable” séparant les modèles “gpt2” des autres modèles (dont GPT-4-Turbo, le précédent modèle d’OpenAI) d’environ 50 points ELO. Elle avait également souligné des améliorations dans tous les domaines testés, notamment les capacités de raisonnement et de programmation.

Sur les réseaux sociaux, les spéculations allaient bon train concernant ces nouveaux modèles : les ingénieurs d’OpenAI étaient-ils en train de tester leur prochain modèle ? Sera-t-il annoncé lors de la prochaine conférence de l’entreprise ? Ce futur modèle pourrait-il être même GPT-5 ? L’anticipation pour le prochain évènement d’OpenAI, la Spring Update du 13 mai 2024, était donc à son paroxysme et les tweets cryptiques du patron Sam Altman ne faisaient qu’augmenter la hype.

Ce lundi 13 mai, OpenAI a donc mis fin aux rumeurs en annonçant la nouvelle : ces tests étaient bien les prémices d’un nouveau modèle venant redéfinir l’état de l’art en matière d’IA générative : GPT-4o.

GPT-4o : meilleur en tous points ?

Si OpenAI a nommé son dernier modèle GPT-4o, c’est pour mettre en exergue le domaine où il excelle le plus selon ses créateurs : la multimodalité. En effet, le “o” signifie “omni” pour souligner la prise en charge native de multiples modes de communication : le texte, l’audio et l’image.

Côté texte, GPT-4o dispose d’une compréhension et d’une capacité de raisonnement similaire voire légèrement supérieure à son prédécesseur GPT-4 Turbo. Le nouveau modèle réalise par exemple un nouveau record de 88.7% au test MMLU (questions de culture générale) contre 86.5% pour GPT-4 Turbo.

GPT-4o bénéficie par ailleurs d’une tokenization plus efficace. La tokenization est le procédé par lequel un modèle de langage transforme des mots du langage naturel en “tokens”, des suites de caractères qui peuvent ensuite être interprétés par l’algorithme prédictif du modèle de langage. Lire mon précédent post pour en savoir plus.

Le texte suivant est transformé en 28 tokens par GPT-4o :

“Bonjour, je m'appelle GPT-4o. Je suis un nouveau type de modèle de langage, c'est un plaisir de vous rencontrer!”

C’est 1.1x moins que GPT-4 Turbo (31 tokens), et cette amélioration est valable aussi en anglais, en espagnol ou en portuguais. Mais pour d’autres langues, notamment celles qui utilisent d’autres alphabets, l’amélioration est beaucoup plus notable (jusqu’à 4.4x pour le Gujarati, une langue indienne). Le nouveau modèle GPT-4o est donc bien plus performant que son prédécesseur avec les autres langues que l’anglais, en termes de rapidité d'exécution mais aussi de compréhension et de traduction.

Concernant l’audio, l’accent est mis sur la rapidité : OpenAI annonce une vitesse fulgurante de 320 millisecondes pour répondre à instructions vocales. À titre de comparaison, le Voice Mode de ChatGPT avait un délai moyen de 2.8 secondes pour GPT3.5 et 5.4 secondes sur GPT-4 ! Cette différence de performance s’explique par un fonctionnement différent : auparavant, une instruction vocale était d’abord transcrite de l’audio au texte par un premier modèle, puis répondue en text-to-text par GPT3.5 ou GPT4, puis retranscrite du texte vers l’audio par un troisième modèle. Désormais, les trois modes de communication sont entraînés par le même réseau neuronal, celui de GPT-4o, ce qui lui permet d’interpréter le ton, les différents interlocuteurs, les sons en arrière-plan mais aussi de répondre en chantant, de rire ou d’exprimer des émotions.

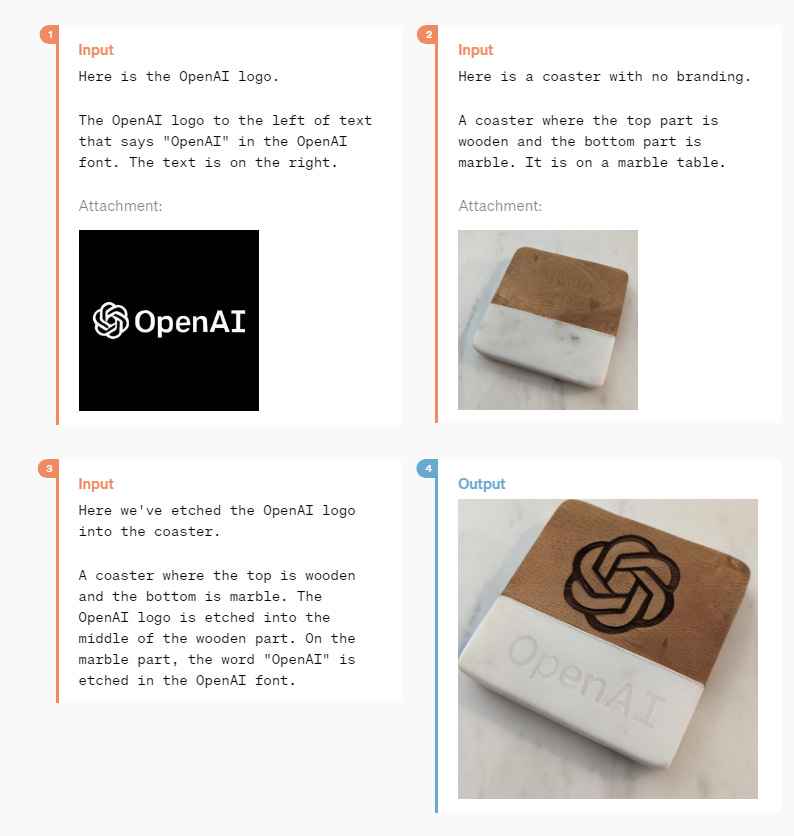

Enfin, GPT-4o vient également avec de nombreuses évolutions en ce qui concerne l’interprétation et la génération d’images et même de vidéos. Le nouveau fonctionnement multimodal du modèle lui permet par exemple de prendre une image ou une vidéo en instruction et de répondre par une autre image. Voici quelques exemples illustrant ces nouvelles possibilités :

Le plus bel exemple des nouvelles capacités de GPT-4o est certainement l’agent conversationnel développé en collaboration avec BeMyEyes : une application permettant aux personnes malvoyantes ou non-voyantes d’obtenir une audiodescription du monde qui les entoure et de se faire assister dans certaines tâches.

Lors de la conférence de presse, la responsable technique d’OpenAI Mira Murati a aussi expliqué de possibles futures évolutions comme laisser GPT-4o observer un match, décrire ce qui s’y passe et expliquer les règles du jeu.

OpenAI n’a pas manqué de nous faire la démonstration de toutes ces nouvelles fonctionnalités impressionnantes dans plusieurs vidéos disponibles en anglais dans le communiqué de presse : on peut y voir GPT-4o assister une personne aveugle pour prendre le taxi grâce à BeMyEyes, faire de la traduction en temps réel, jouer à pierre-feuille-ciseau, chanter une berceuse etc.

Un outil déjà accessible au grand public

La meilleure nouvelle de toutes est peut-être celle-ci : GPT-4o est d’ores et déjà disponible gratuitement pour tous les utilisateurs de ChatGPT. Les utilisateurs gratuits peuvent désormais utiliser de façon limitée le nouveau modèle (la limite étant de quelques essais du nouveau modèle pendant un temps imparti avant de revenir sur la précédente version gratuite, GPT3.5-Turbo). Les souscripteurs aux formules payantes Plus et Teams bénéficient eux d’un accès illimité au nouveau modèle GPT-4o. Pour les développeurs, GPT-4o est 2x moins cher que son prédécesseur tout en étant, rappelons le, plus rapide et performant.

De nombreux exemples de nouvelles applications impressionnantes commencent déjà à pulluler sur les réseaux sociaux. En voici quelques uns :

“Analyse ce fichier Excel et génère une analyse technique et statistique profonde. Génère des graphiques et des visualisations”.

GPT-4o répond par plusieurs graphiques et une analyse détaillée des données :

“Génère un fichier 3D d’une table avec 4 pieds et des attributs aléatoires”.

GPT-4o répond en générant un fichier STL d’une table en 3D :

“Transcris ce vieux manuscrit du XVIIIe siècle”.

GPT-4o transcrit parfaitement en texte un manuscrit que bien peu de gens seraient capable de transcrire à la main.

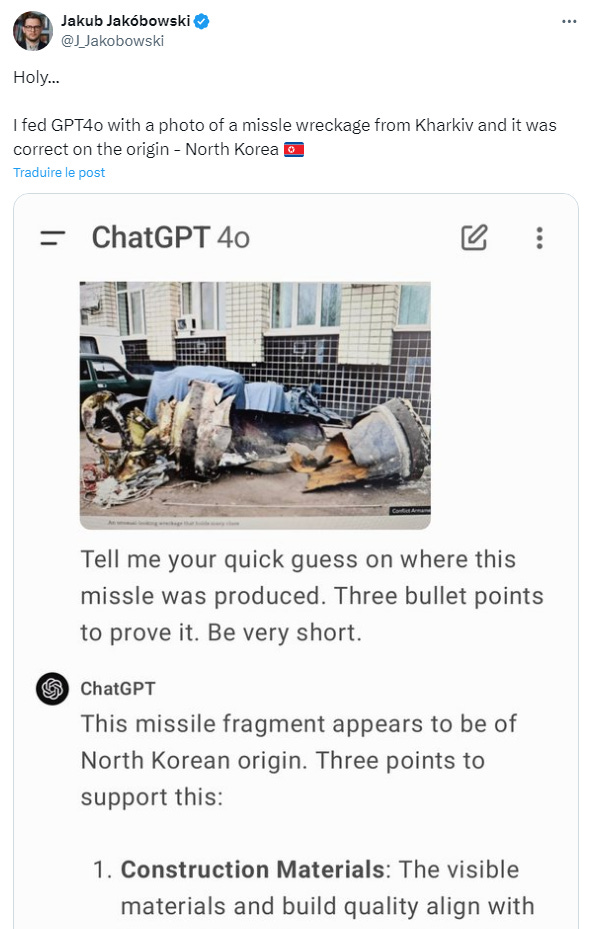

“Identifie quel pays a conçu ce missile d’après cette photo”.

GPT-4o identifie avec succès que le missile photographié est d’origine nord-coréenne d’après son analyse des matériaux, de la conception et du contexte de la photo.

Avec ce nouveau modèle, OpenAI met la barre haute pour toutes les entreprises concurrentes, et pas seulement celles qui créent et distribuent des modèles de langage.

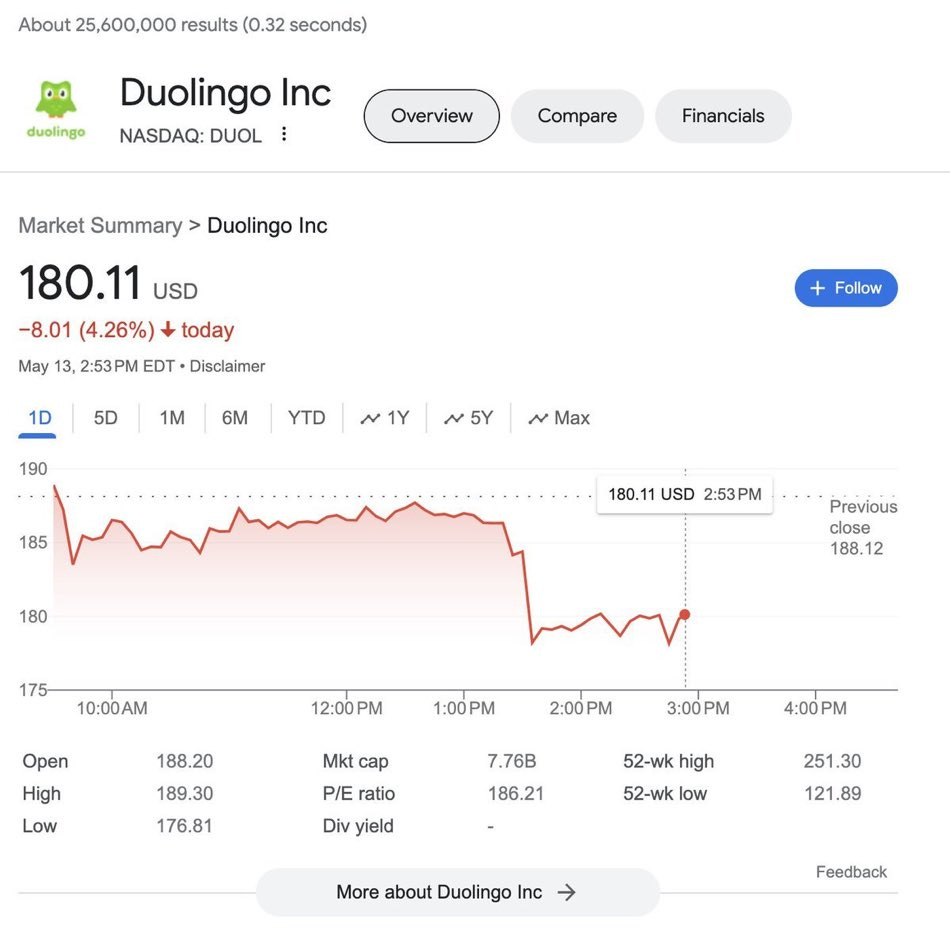

Lors de la conférence d’OpenAI, l’une des démonstrations consistait à démontrer que GPT-4o pouvait aider à apprendre une nouvelle langue. Un démonstrateur pointait alors le téléphone vers différents objets pour en demander la traduction en espagnol en temps réel. Quelques minutes plus tard, la valeur de l’entreprise Duolingo (une application permettant d’apprendre de nouvelles langues) a baissé d’environ 340 millions de dollars !

Sorti il y a tout juste 24 heures à l’heure où j’écris ces lignes, il est encore trop tôt pour pouvoir juger de l’ampleur des opportunités (et des menaces) qu’apporte ce nouveau modèle de langage GPT-4o. Cependant, beaucoup d’observateurs avertis ont déjà apporté leur conclusion au débat : GPT-4o est le grand modèle de langage le plus performant sur le marché. Il témoigne d’une nouvelle avancée majeure dans le domaine de l’intelligence artificielle générative et est un pas de plus vers la création de programmes toujours plus autonomes.

Dans mon prochain post, je vous parlerai des AI Wearables, ces accessoires à porter sur soi et qui embarquent l’intelligence artificielle pour nous assister au quotidien… ou pas ?

Très intéressant, bonne rédaction, c'est digeste !

Très complet 😉