Le Rabbit R1, OpenAI porte plainte, un GPT Store prochainement ?

Trois actualités du début 2024

Ceci est un post de mon ancienne veille privée datant du 10 janvier 2024

Le New York Times porte plainte contre OpenAI, OpenAI répond

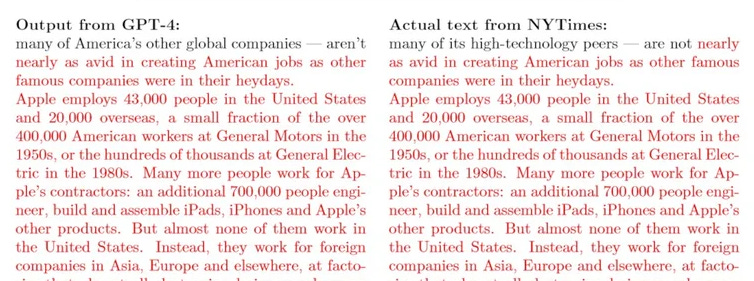

Il y a 2 semaines environ le groupe d'édition du New York Times a porté plainte contre OpenAI (la société qui a créé ChatGPT) pour infraction au droits d'auteur. Parmi les pièces apportées au dossier, une comparaison entre une réponse de GPT-4 et un article du New York Times :

On peut voir que la réponse de GPT est identique à l'article du New York Times, évidemment sans citer la source du propos. Une preuve irréfutable selon le NYT que OpenAI est coupable de contrefaçon et de plagiat.

C'est le premier procès sérieux d'une énorme société média envers un acteur de l'intelligence artificielle et de nombreux opposants à l'IA ont beaucoup d'espoir et d'attente quant à l'issue de ce procès. L'enjeu est de savoir si les LLM (les modèles de langages tels que GPT), qui ne peuvent fonctionner qu'en collectant une énorme masse de contenu déjà existant (comme des articles de presse), représentent une infraction au droit d'auteur.

Le même problème se pose d'ailleurs pour les IA génératives d'images telles que DALL-E ou Midjourney qui génèrent des images à partir de millions de créations d'artistes bien réels et non consentants, dont on retrouve parfois même les signatures sur les images générées.

Il faut savoir que GPT tire ses connaissances de plusieurs énormes bases de données dont celle appellée "Common Crawl" : une base de données open source qui contient plus de 250 milliards de pages web indexées (3 à 5 milliards en plus chaque mois) et qui contient notamment l'ensemble des articles de Wikipédia, New York Times, Washington Post etc.

L'issue de ce procès pourrait être de forcer les IA à citer leurs sources "d'inspiration" quand elles génèrent un contenu (texte, image ou autre), à rémunérer ces mêmes sources quand leur travail est utilisé, voire même d'interdire complètement les IA construites sur des contenus sans le consentement de leurs auteurs. Le New York Times dispose donc de nombreux soutiens dans cette bataille judiciaire qui fera office de jurisprudence et qui est scrutée dans le monde entier, et c'est par ailleurs une entreprise réputée pour savoir s'entourer d'armées d'avocats experts qui ont déjà remporté de grosses affaires de copyright.

Le patron de OpenAI, Sam Altman, a réagi en disant que ce procès était une "surprise et une déception" qui intervient alors que OpenAI et NYT étaient déjà bien avancés dans des négociations. Selon lui, le phénomène montré dans la capture ci-dessus est un phénomène de régurgitation. Un nouveau terme à connaître dans l'IA, qui décrit la situation dans laquelle un modèle de langage comme GPT "régurgite" tel quel un texte qu'il a appris dans ses bases de données. Selon Sam Altman, le New York Times a volontairement manipulé GPT-4 pour obtenir ce résultat identique à la source originale. Le prompt qui a amené cette réponse était en effet un copier coller du début de l'article mot-pour-mot. GPT fonctionnant par calculs de probabilités, il a calculé que la meilleure réponse à ce prompt était de régurgiter la suite de l'article au mot près. Selon Altman les poursuites sont donc sans fondement.

Toute la communauté IA dans le monde a les yeux rivés sur cette affaire judiciaire, je vous tiendrais donc au courant de la suite de cette histoire.

Bienvenue aux LAM, un nouveau type d'IA et d'objet révolutionnaire

Je vous ai déjà parlé des LLM, ce sont les Large Language Models, la technologie qui permet à GPT et autres modèles de langages de comprendre le langage naturel d'un humain, et de lui répondre en langage naturel. Cette technologie s'appuie comme évoqué plus haut sur des énormes bases de données (c'est comme ça qu'elles apprennent comment et de quoi les humains parlent) mais aussi sur de complexes calculs de probabilité. Le but d'un LLM est en fait de deviner la suite de mots la plus probable dans une interaction avec un humain. Donc si je demande à un LLM "Qui est le président de la France ?", il va d'abord découper mon prompt pour le comprendre : il y a un "?" à la fin donc c'est une question ; elle commence par "Qui" donc la réponse la plus probable sera un nom ; "président de la France" ça c'est quelque chose qu'il a déjà vu dans ses données d'apprentissage, il va donc rechercher dans sa base de données et ensuite calculer que la meilleure réponse, la plus probable, c'est "Emmanuel Macron".

Voir mon post “Qu’est-ce que l’intelligence artificielle générative”

Des fois, ce qu'un LLM calcule comme la réponse la plus probable est en fait une erreur, et c'est comme ça que les LLM peuvent halluciner (autre terme important dans l'IA), c'est à dire sortir des réponses complètement fausses.

Exemple d'hallucination de GPT quand on demande de créer une recette :

Aujourd'hui même mon flux Twitter est complètement submergé par une annonce révolutionnaire dans le domaine de l'IA : une entreprise a annoncé publiquement avoir créé une nouvelle entité d'IA. Ce n'est pas un LLM mais un LAM pour Large Action Model. Le sujet est un peu complexe mais je vais essayer de vous le résumer car c'est très, très intéressant :

Le but d'un LLM est de comprendre les interactions entre humains lorsqu'ils se parlent entre eux, pour pouvoir les répliquer.

Le but d'un LAM est de comprendre les interactions entre un humain et une machine, pour pouvoir les répliquer.

Le LAM analyse comment nous utilisons les interfaces de nos ordinateurs pour pouvoir les répliquer par la suite. Par exemple, je suis sur un site e-commerce, je me connecte en cliquant sur tel bouton, je cherche un produit dans la barre de recherche qui se trouve à tel endroit, puis si je veux l'acheter je l'ajoute à mon panier en cliquant sur tel autre bouton etc. En analysant toutes ces interactions, le LAM est capable ensuite de répliquer toutes ces actions : se connecter, chercher et afficher un produit, ajouter au panier etc.

Le plus excitant, c'est que cette fameuse entreprise a annoncé avoir créé un LAM, mais aussi l'avoir intégré à un nouvel objet révolutionnaire. Ce n'est pas un ordinateur, ce n'est pas un smartphone, c'est un pocket companion.

Il n'a pas d'interface : on l'utilise en lui parlant, et il nous répond en nous parlant.

On peut alors prendre le companion dans la main, appuyer sur un bouton et dire : "achète moi un produit X sur le site web Y". En coulisses, il va donc aller sur le site web, se connecter, rechercher le produit, ajouter au panier etc. comme il l'a appris dans ses données d'apprentissage. S'il est bloqué dans son parcours il peut intervenir et par exemple demander "rappelez moi vos identifiants de connexion" ou "le produit X n'est pas en stock mais il existe en version Z qui elle est en stock, voulez vous acheter celle-là ?".

Autres exemples :

- "Réserve moi une séance de kiné" => le compagnon va se rendre sur doctolib, proposer les créneaux et praticiens disponibles etc

- "Voici comment s'est passée ma réunion de ce matin" => le compagnon va résumer, enregistrer dans le CRM

- "Dis à Christophe Typret de se dépêcher de sortir le nouveau site" => le compagnon va se connecter à vos emails et rédiger un email et l'envoyer tout seul

Vous pouvez regarder la keynote d'annonce qui est passionnante mais en anglais seulement

Je vous ai fait un petit résumé des fonctionnalités annoncées ci-dessous :

Le rabbit R1 est un pocket companion qui dispose :

- D'un écran tactile

- D'une caméra 360° appelée "rabbit eye"

- D'un bouton "push to talk"

- D'une molette de défilement

- Bluetooth, wifi, 4G

Vous pouvez appuyer sur le bouton "push to talk" pour poser n'importe quelle question à rabbit comme on peut le faire avec ChatGPT ou Copilot. La différence est la vitesse : rabbit vous répond 10x plus vite que les autres chatbots IA, avec une réponse en dessous de 500 millisecondes.

Quand on secoue le rabbit R1, un clavier apparait pour nous permettre de taper plutôt que de parler à l'oral.

Exemple quand on demande le prix de l'action Coca Cola :

Ou quand on demande quel est l'acteur principal dans le dernier film de Christopher Nolan :

On peut aussi connecter différentes applications, par exemple connecter spotify et demander "joue moi telle playlist" :

La démo continue sur d'autres exemples :

- "Commande moi une course Uber"

- "Planifie moi un voyage à Londres en prenant les vols et les hôtels les moins chers"

La démo passe ensuite sur la fonctionnalité "Vision" où on montre le contenu d'un frigo à la caméra et on demande une recette selon les ingrédients disponibles

Mais ça va encore plus loin lorsqu'il filme son écran sur Excel et demande au compagnon d'ajouter une colonne avec une formule. Le compagnon lui envoie le fichier excel modifié par email :

Le démonstrateur répond ensuite à l'email pour demander l'ajout d'une colonne en plus. Le rabbit lui répond par email avec le nouveau fichier modifié : les interactions avec rabbit ne s'arrêtent donc pas au seul compagnon de poche mais peuvent aussi se poursuivre sur d'autres canaux comme l'email.

La démo ensuite explique le "Teach mode", une fonctionnalité qui permet à l'utilisateur d'apprendre un process ou une tâche unique au rabbit pour pouvoir ensuite la déclencher automatiquement. Après avoir déclenché le teach mode, le démonstrateur se filme juste en train de réaliser sa tâche (par exemple : créer une score card sur excel) et explique à l'oral les différentes étapes. Comme le rabbit est équipé de ce fameux LAM permettant de comprendre les interactions entre l'humain et son ordinateur et de les répliquer, on pourra alors à l'avenir lui demander de créer la score card et de l'envoyer tout seul.

La démo se termine en expliquant que le rabbit r1 n'a pas été créé pour remplacer les smartphones mais plutôt pour permettre de faire des choses qui sont impossibles à faire pour les smartphones car ils sont fondamentalement basés sur le fait de passer d'une app à l'autre pour réaliser des tâches.

Le rabbit r1 est à vendre dès maintenant pour 199$ et les livraisons commenceront à Pâques 2024.

OpenAI va lancer un GPT Store

OpenAI a annoncé la volonté de lancer un GPT Store dès la semaine prochaine, ouvrant ainsi la voie à un tout nouveau marché d'applications basées sur l'IA. Il existait déjà un système d'applications ou plugins sur GPT qui a permis à certaines entreprises de proposer une intégration à leurs services directement dans GPT. Par exemple, grâce au plugin "Expedia" (le célèbre site de voyage), on pouvait demander à GPT "réserve moi un avion entre charles de gaulle et los angeles" : GPT interrogeait alors en coulisses les services d'Expédia, et proposait ensuite de cliquer sur un lien pour terminer la réservation sur le site d'Expedia. L'ouverture d'un GPT Store devrait permettre d'aller plus loin dans cette direction (par exemple ne plus avoir besoin d'aller sur le site d'expédia pour valider sa réservation, mais pouvoir le faire tout en restant dans ChatGPT) et surtout de permettre au plus grand nombre d'entreprises et de particuliers de développer et de proposer des applications sur ce store.