OpenAI sort un nouveau modèle toujours plus intelligent : o1

Et autres nouvelles de la rentrée : nouveaux modèles vidéo, une IA qui lit sur les lèvres, un nouveau produit Google, 1 milliard pour créer la Superintelligence et une grosse arnaque.

OpenAI, le mastodonte de l’intelligence artificielle derrière ChatGPT vient d’annoncer la publication d’une nouvelle génération de modèles baptisée o1. C’est l’occasion également de faire le point sur les autres nouveautés concernant le monde de l’IA !

Une nouvelle gamme conçue pour résoudre les problèmes complexes

Cela faisait des semaines que la rumeur courait sur les réseaux sociaux et dans les couloirs des conventions tech : OpenAI serait sur le point de sortir un nouveau modèle encore plus intelligent et plus performant que GPT-4o. Baptisé “Strawberry” (Fraise en français), ce projet a attisé la curiosité de tous les observateurs du milieu. Serait-ce GPT-5 ? Peut-être même que OpenAI et son dirigeant Sam Altman ont atteint leur objectif, à savoir de créer la première AGI (Intelligence Artificielle Générale) de l’histoire de l’humanité capable de surpasser les humains dans n’importe quelle tâche.

La nouvelle vient de tomber : il ne s’agit pas d’AGI ou de GPT-5, mais d’une nouvelle gamme de modèles d’IA générative appelée o1.

Selon les créateurs, o1 est une nouvelle série de modèles prévus pour passer plus de temps à réfléchir avant de répondre. Ils peuvent ainsi raisonner sur des tâches et des problèmes plus complexes, notamment en science, en programmation et en mathématiques.

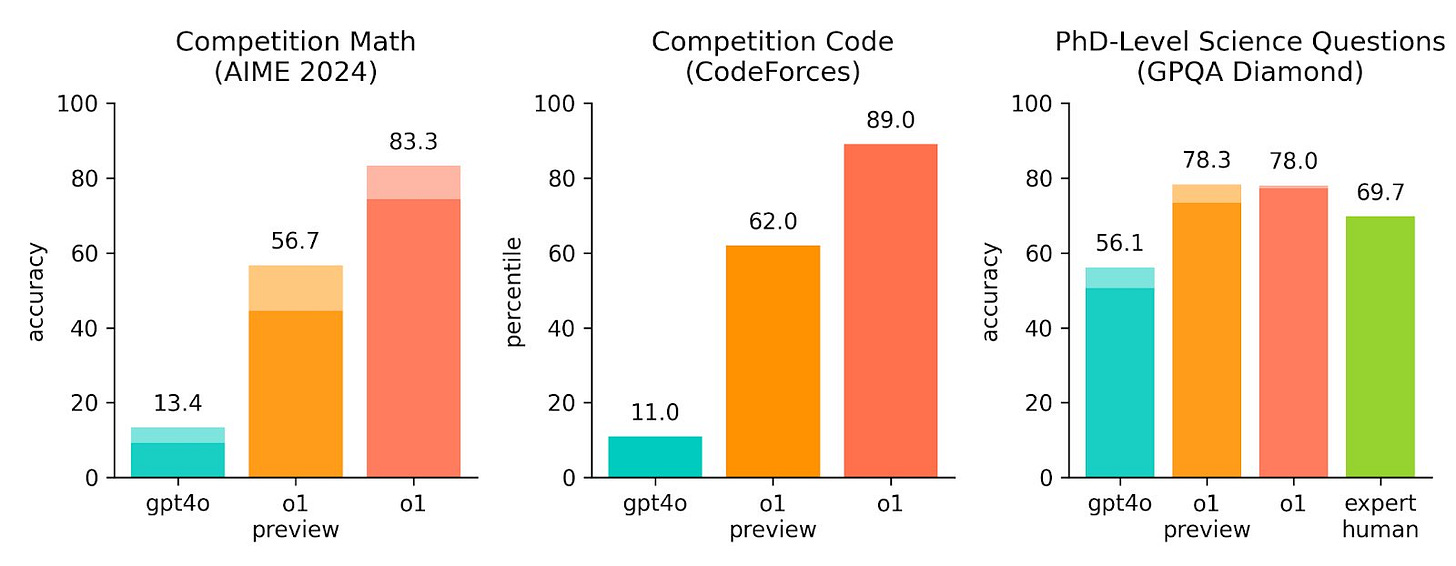

Les essais fournis par OpenAI montrent en effet que le modèle o1 obtient de meilleurs résultats sur différents tests que le modèle précédent GPT-4o, notamment sur une compétition de mathématiques, une compétition de programmation et des questions scientifiques de niveau doctorat (voir ci-dessous).

Ce gain de performance vient de la capacité des modèles o1 à “réfléchir” ou “raisonner” avant de répondre à un prompt, via la génération d’une “chaîne de réflexion”. Cela signifie aussi que plus le modèle met du temps à réfléchir avant de répondre, plus ses réponses sont correctes. Actuellement, o1 répond en quelques secondes, mais l’idée des créateurs pour de futures versions est de lui permettre de réfléchir pendant des heures, des jours, ou même des semaines. Théoriquement, cela lui permettra de trouver des solutions à des problèmes extrêmement complexes et pourquoi pas, de trouver un remède pour le cancer, d’inventer un nouveau type de batteries révolutionnaires, ou de prouver des théorèmes encore indémontrables. Oui, oui, ce sont bien les exemples cités par le chercheur d’OpenAI Noam Brown qui a travaillé sur le modèle !

Au-delà de ces ambitions, les créateurs de o1 ont remarqué qu’ils pouvaient intégrer leurs “règles de sécurité” au sein de la chaîne de réflexion afin de lui permettre de raisonner en prenant en compte les “valeurs et principes humains” dans le contexte de la tâche demandée. Cela permet à OpenAI de proposer un modèle beaucoup plus sûr, mieux sécurisé contre les techniques de “jailbreak” (des techniques utilisées pour contourner les règles de sécurité du modèle et par exemple générer du contenu sexuel, illégal, encourageant au suicide ou au harcèlement etc.)

Comme d’habitude avec OpenAI, les modèles sont aussitôt annoncés, aussitôt disponibles. Voici les versions disponibles dès le 12 septembre pour les utilisateurs de ChatGPT Plus, Team, Enterprise, Edu et API :

o1-preview est une version “avant-première” du modèle o1 permettant aux chercheurs d’OpenAI de confronter leur modèle au marché et faire si besoin quelques ajustements avant de publier la version o1 définitive. Ce modèle est limité pour le moment à 30 messages par semaine.

o1-mini est une version plus légère et 80% moins coûteuse que o1-preview, surtout dédiée à répondre rapidement à des prompts liés à la programmation pour les développeurs. Un modèle limité pour le moment à 50 messages par semaine, ou à 20 requêtes par minute via API (pour les développeurs ayant déjà dépensé plus de 1000$ chez OpenAI).

Ces versions sont par ailleurs limitées puisqu’elles ne sont pas compatibles avec certaines fonctionnalités comme l’ajout de pièces jointes.

Attention cependant, ces modèles ne sont pas forcément meilleurs que la génération précédente GPT-4o pour toutes les tâches ! Si o1 est bien meilleur sur les sujets liés à la programmation, à la science ou aux mathématiques, il offre pour le moment de moins bonnes performances pour d’autres tâches telles que la génération ou l’édition de contenu textuel. OpenAI le précise : les modèles o1 sont avant tout conçus pour les scientifiques et les développeurs. On est donc encore loin d’une AGI (Intelligence Artificielle Générale) permettant de surpasser les humains sur n’importe quelle tâche, mais voilà certainement un pas en plus vers cet objectif pour OpenAI, et probablement aussi un nouveau coup d’avance sur ses concurrents.

Du nouveau sur l’IA et la vidéo

Une fois n’est pas coutume, le monde de la génération de vidéos via l’intelligence artificielle a bien évolué depuis notre dernier point sur le sujet. De nouvelles technologies sortent chaque semaine et les résultats sont de plus en plus bluffants, à un point tel qu’il devient difficile de faire la différence entre des contenus vidéo générés par l’IA et de réelles vidéos.

Voici un florilège des toutes dernières nouveautés :

L’IA bientôt au cinéma ?

À partir d’un simple prompt pour chaque scène (par exemple : “dans une pièce sombre, un agent portant un costume et un chapeau enfonce une porte, effet silhouette), l’étudiant en cinématographie, réalisateur en herbe et enthousiaste de l’IA Elson Huanglu Lu a créé le (très) court métrage suivant que beaucoup d’amateurs trouvent assez bluffant. Il a utilisé le modèle Minimax qui vient tout juste d’être publié par la société chinoise Hailuo AI. Voir ci-dessous :

Vous pouvez voir plus d’exemples générés par ce nouveau modèle chinois Minimax sur ce post X. Ce modèle rivalise désormais avec les autres meilleurs modèles du marché tels que Runway, Kling ou Dream Machine. Voici d’ailleurs ci-dessous une vidéo générée par Arthur Benhamou utilisant Midjourney pour générer les images de base puis Runway pour les animer.

N’est-ce plus qu’une question de temps avant que nous puissions voir l’IA au cinéma ?

Une IA capable de lire sur les lèvres

La société Symphonic Labs vient de créer un modèle capable de lire sur les lèvres et donc de générer un texte à partir d’une vidéo. La technologie est accessible via le site gratuit ReadTheirLips.com. Le résultat n’est pas encore parfait mais le but du site gratuit est d’entraîner le modèle pour qu’il obtienne une meilleure performance. Certains y voient déjà des applications pratiques, dans des smart glasses (lunettes connectées) ou même dans la surveillance de masse. Vous reprendrez bien un peu de dystopie ?

Google Vids : la génération de vidéo par Google

Google vient de déployer son tout nouvel outil au sein de la gamme Gemini (voir mon post détaillé ici) : Google Vids. La promesse est simple : à partir d’un prompt, Google Vids peut générer plusieurs scènes personnalisables (à la manière de Slides dans Google Slides) et les monter en une seule vidéo, mais aussi écrire un script, générer une voix-off etc... L’outil est avant tout dédié à la création de vidéos pour les entreprises.

Comme dans Slides, il existe plusieurs templates pour ne pas commencer de zéro : vidéo de présentation de produit ou d’un nouvel employé, session de questions/réponses, avis client, arrivée d’un nouvel employé, rapport d’activité etc. Google Vids est pour le moment testé par une poignée d’utilisateurs au sein de Google Workspace Labs. L’un d’eux a publié la démonstration suivante :

Autres nouvelles de la rentrée

Au-delà des nouvelles liées à la vidéo, je voulais aussi vous partager ces deux petites brèves importantes qui ont fait énormément parler dans l’univers de l’IA.

La startup SSI lève 1 milliard de dollars

Un nouveau mastodonte dans la course à l’intelligence artificielle ? Ancien co-fondateur et Chief Scientist de OpenAI, Ilya Sutskever a quitté le navire et est désormais co-fondateur et Chief Scientist de Safe Superintelligence Inc (ou SSI) aux côtés de Daniel Gross (qui a vendu sa première startup à Apple à l’âge de 22 ans pour 50 millions de dollars) et Daniel Levy (ancien d’OpenAI titulaire d’un doctorat de Stanford, passé par Polytechnique et même Louis-le-Grand, ancien stagiaire chez Microsoft, Facebook et Google). Qui de mieux que cette dream team pour lever 1 milliard de dollars auprès des meilleurs investisseurs américains avec un seul et unique objectif : inventer la superintelligence sécurisée (Safe superintelligence). C’est-à-dire créer des systèmes d’intelligence artificielle capables de surpasser (de très loin) les capacités humaines, mais en mettant l’accent sur l’aspect “sécurisé” et donc à priori sans risque d’abus. L’entreprise est (évidemment) américaine avec des bureaux en Californie et en Israël. Les fonds sont d’ores et déjà utilisés pour recruter les meilleurs ingénieurs IA du monde avec une promesse : “l’opportunité d’accomplir le travail de votre vie et d’aider à résoudre le défi technique le plus important de notre ère”. Rien que ça !

Reflection 70B : un modèle révolutionnaire ou une pure arnaque ?

Le 5 septembre, le patron de OthersideAI, Matt Shumer, annonce une avancée révolutionnaire dans le monde de l’IA : un modèle conçu avec une nouvelle technique permettant aux LLM (modèles de langage) de corriger eux-mêmes leurs propres erreurs. Baptisé Reflexion 70B, il aurait obtenu de meilleurs résultats que tous les autres modèles actuels sur plusieurs bancs d’essai, et est même open source, ce qui signifie qu’il serait accessible à tous sans limites et représenterait donc un grand pas en avant pour toute la communauté IA.

Tout le monde se met alors à télécharger le modèle et cherche à reproduire les tests. Problème : la performance n’est pas du tout au rendez-vous. Pire encore, Matt Shumer n’aurait pas dit toute la vérité sur son modèle révolutionnaire. D’après les tests réalisés par de nombreux utilisateurs, le modèle serait en fait une surcouche à un modèle bien connu : Claude 3.5 Sonnet de la société AnthropicAI, l’un des LLM les plus performants du moment avec GPT-4o et Gemini 1.5. Malgré les critiques et les preuves, les créateurs continuent aujourd’hui de nier avoir menti à la communauté et que leur modèle révolutionnaire existe vraiment. Plus sceptiques que jamais, les observateurs du monde de l’IA attendent aujourd’hui des preuves concrètes, mais il se pourrait que l’image de OthersideAI soit déjà durablement entachée par ce lancement raté.